|

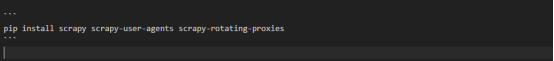

大家好呀,今天我们来聊聊如何在Scrapy中超详细地设置代理服务器。作为HTTP代理产品供应商,我们深知代理服务器在爬虫工作中的重要性。废话不多说,让我们分享一套简单、易懂的设置方法,帮助你轻松爬取数据,告别被封IP的烦恼! 步骤一:安装Scrapy和依赖库 首先,确认你已经安装好Scrapy和相关的依赖库。如果还没安装,别慌!只需在命令行中输入以下命令,自动完成安装:

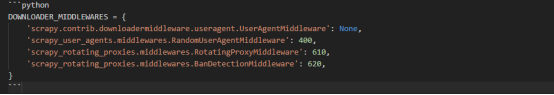

步骤二:获取HTTP代理地址和端口号 在开始设置HTTP代理之前,你需要先获取可用的HTTP代理地址和端口号。作为HTTP代理产品供应商,我们会提供给你一个HTTP代理池,你可以从中选择可用的IP地址和对应的端口号。 步骤三:配置Scrapy设置 1.打开Scrapy工程文件中的`settings.py`文件。 2.找到并取消注释`DOWNLOADER_MIDDLEWARES`,确保其值为以下代码:

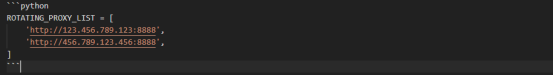

3.找到并取消注释`ROTATING_PROXY_LIST`,并将其值设置为你的HTTP代理地址和端口号的列表,例如:

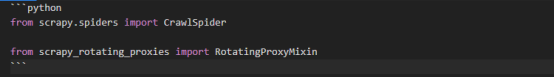

4.保存并关闭`settings.py`文件。 步骤四:编写爬虫代码 接下来,你需要在你的爬虫代码中应用HTTP代理设置。找到你的爬虫文件(通常以`spiders`为后缀),并按照以下步骤进行修改: 1.在导入依赖库的部分,添加以下代码:

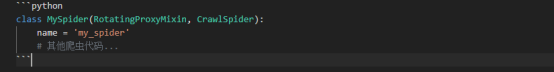

2.在爬虫类的定义中,添加`RotatingProxyMixin`类作为爬虫类的一个父类,例如:

3.保存并运行你的爬虫代码,现在你就可以愉快地爬取数据了! 小提示: -如果在爬虫运行过程中遇到无法访问或被封IP的问题,可能是HTTP代理失效或被限制了。这时你需要与我们的HTTP代理产品供应商联系,获取最新可用的HTTP代理地址列表,并更新`ROTATING_PROXY_LIST`。 -注意定期检查HTTP代理的可用性,并与供应商保持联系,以确保你的爬虫设置始终处于最佳状态。 通过简单的四个步骤,你就能够轻松在Scrapy中设置HTTP代理,畅快爬取数据!别再为被封IP而烦恼,让HTTP代理为你的爬虫工作保驾护航吧! 希望本篇文章对你有所帮助。如果你有任何关于设置ScrapyHTTP代理的问题或心得分享,欢迎在评论区与我们交流! 原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。 如有侵权,请联系 cloudcommunity@tencent.com 删除。 scrapy 原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。 如有侵权,请联系 cloudcommunity@tencent.com 删除。 (责任编辑:) |