|

春节期间deepseek火了,这两天deepseek本地部署火了,很多分享windows电脑本地部署deepseek的方法,本文跟大家分享苹果电脑Macbook本地部署DeepSeek的教程。 原则:不搞那些高深的玩法,让小白也能理解并真正的上手实践。 1.下载Ollama并安装运行DeepSeek 2.下载Chatbox并配置为本地DeepSeek 3.无需联网也能和DeepSeek畅快聊天

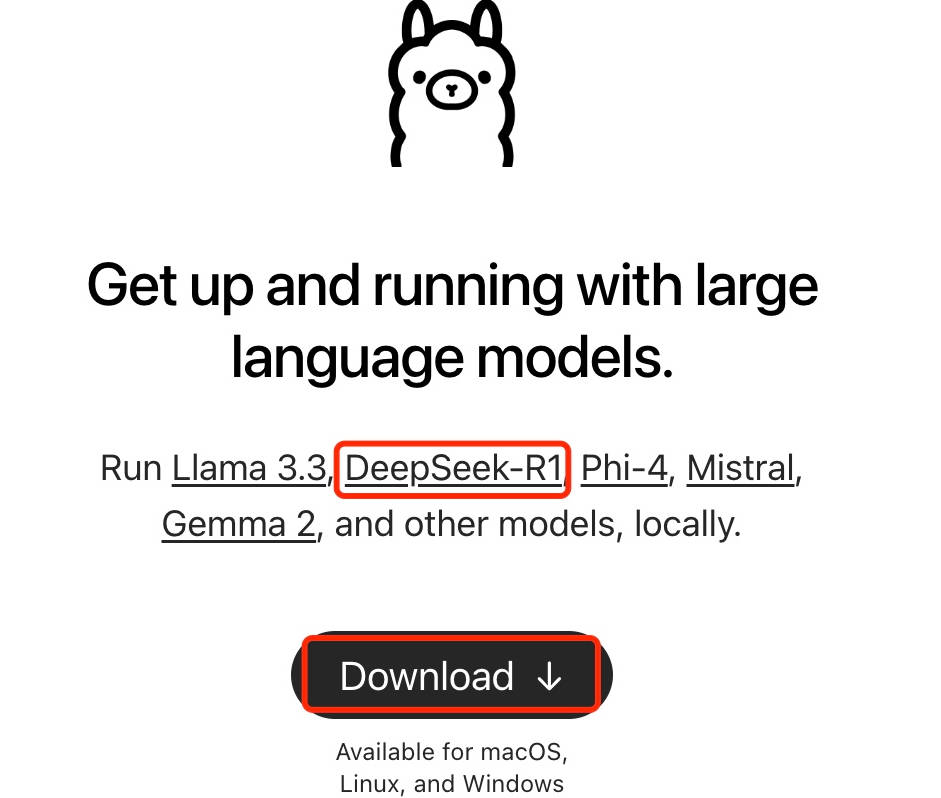

Table of Contents 一、下载Ollama并安装运行DeepSeek1、从Ollama官方网站下载Ollama: 进入Ollama官方网站后,可以看到Ollama已经支持DeepSeek-R1的部署:

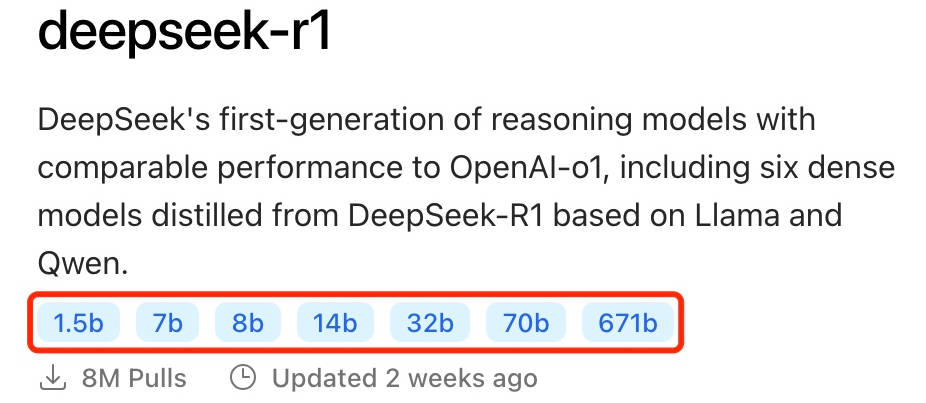

2、点击DeepSeek-R1的链接可以看到有关deepseek-r1的详细介绍:

目前deepseek-r1模型大小提供了7个选择:1.5b、7b、8b、14b、32b、70b、671b。

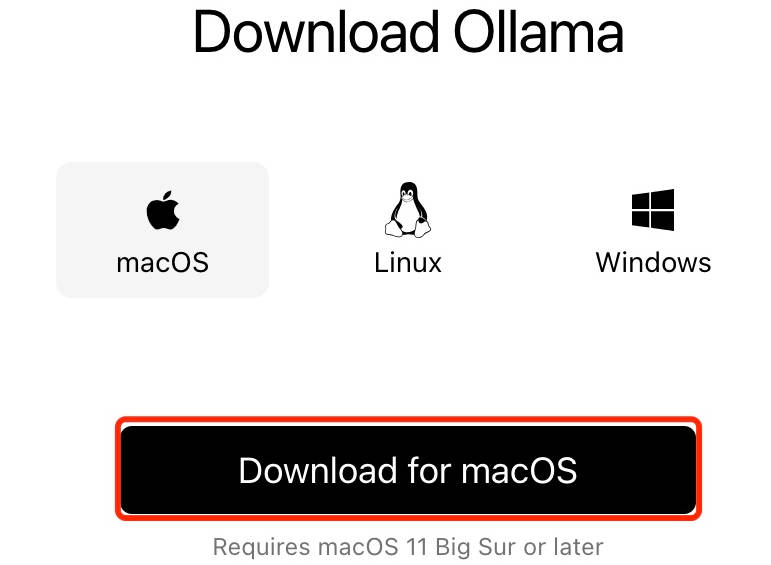

你可以根据你的硬件情况选择,通常模型大小(参数量)越大,模型的理解和生成能力越强,但也会消耗更多的计算资源。 4、点击Download按钮下载符合自己平台的Ollama:

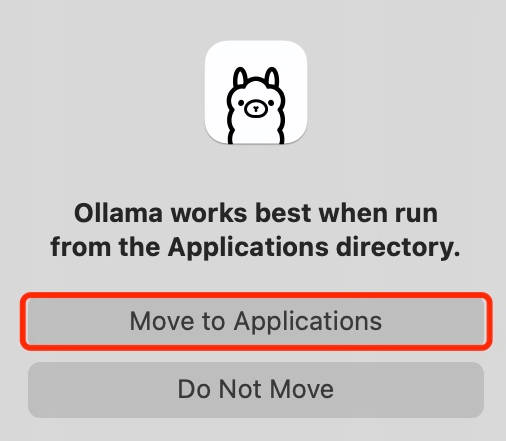

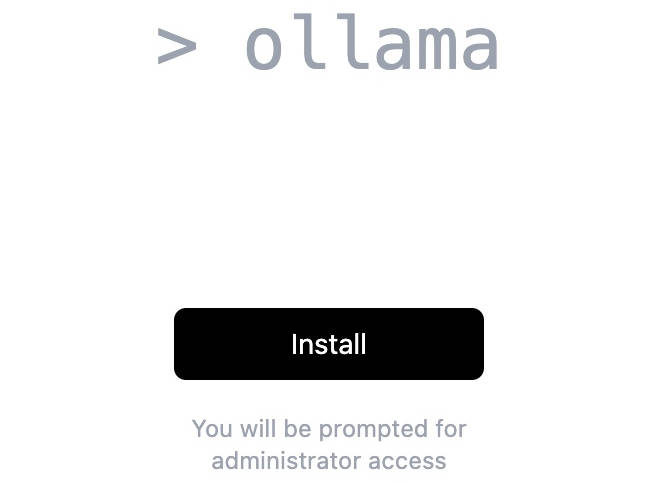

我这里选择macOS,点击下载。 5、解压后打开Ollama应用程序,提示:

6、点击next,点击Install安装ollama。

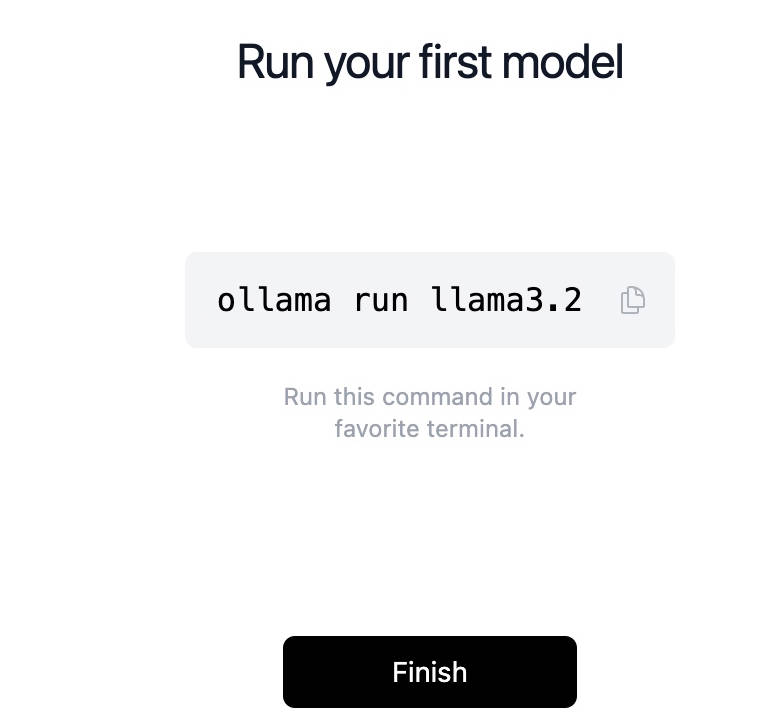

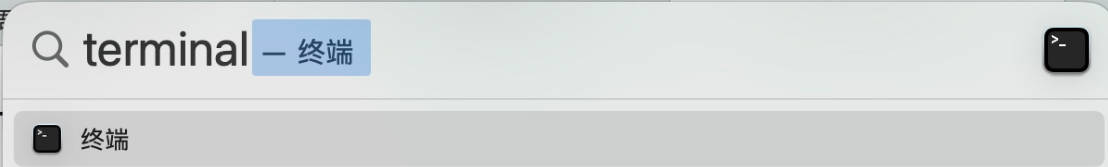

7、按照提示,打开终端,使用 Command + Space 快捷键调用 terminal:

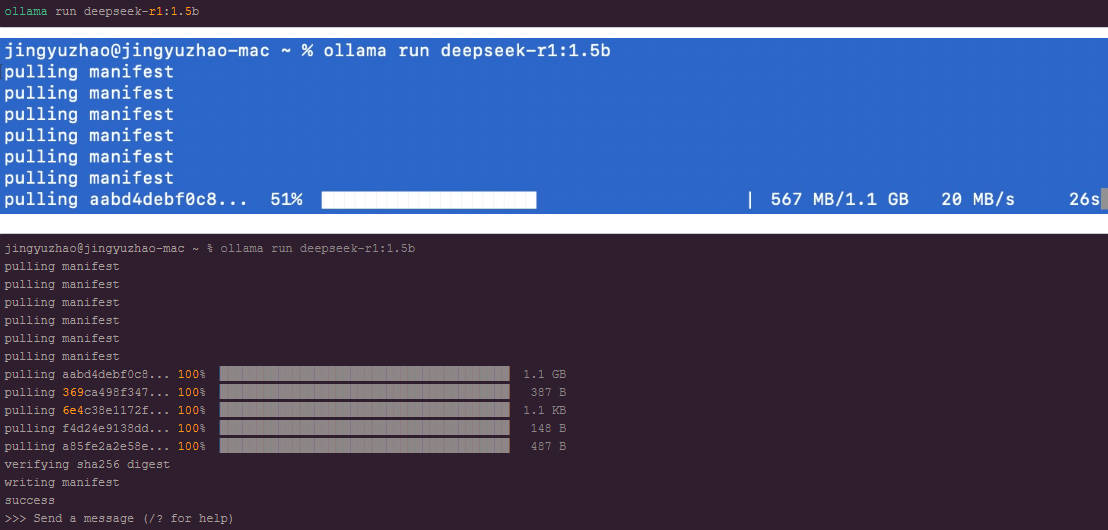

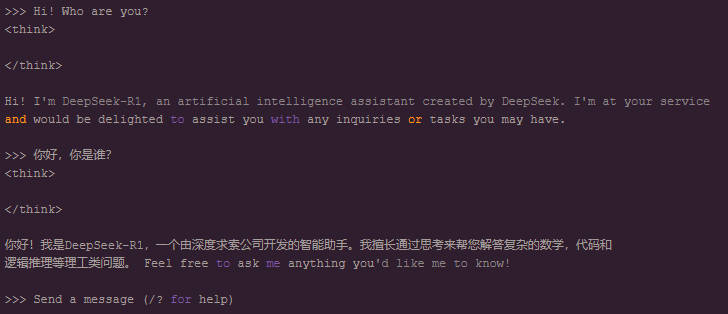

8、这里Ollama默认给出的例子是下载/运行llama3.2大模型,

9、这里就直接可以和DeepSeek对话了:

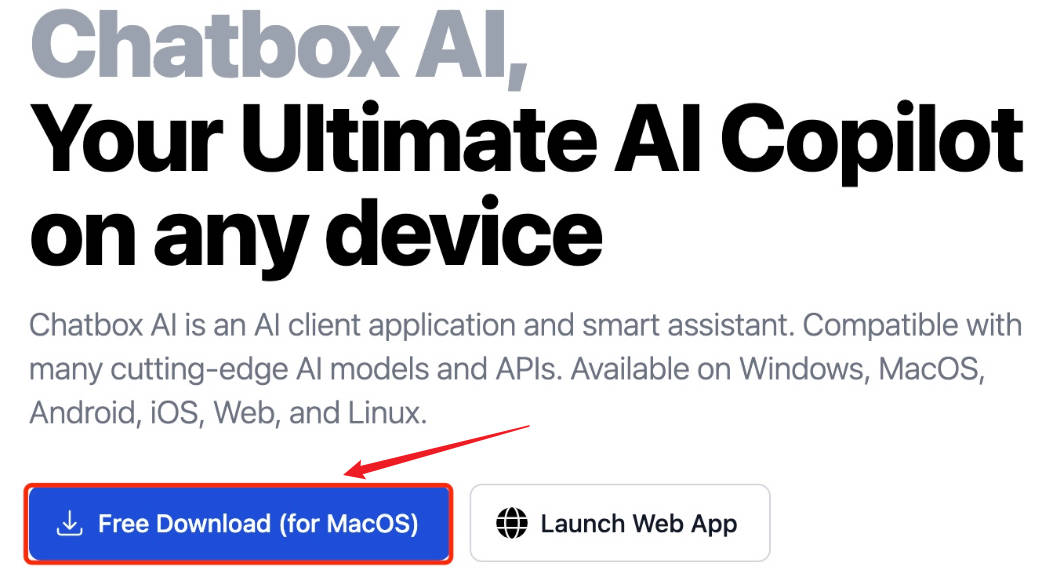

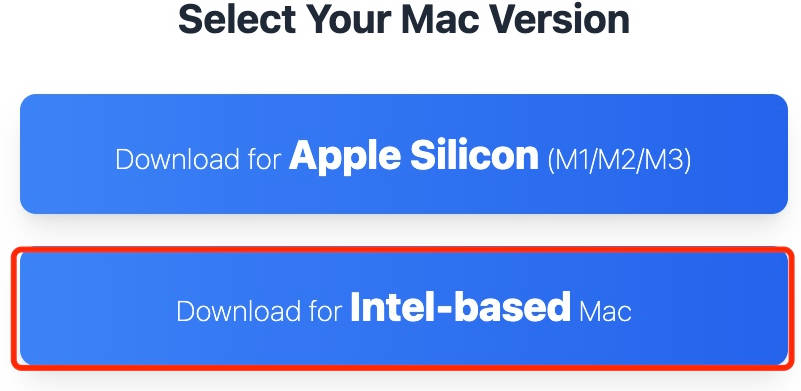

1、打开Chatbox官方网站:https://chatboxai.app/en

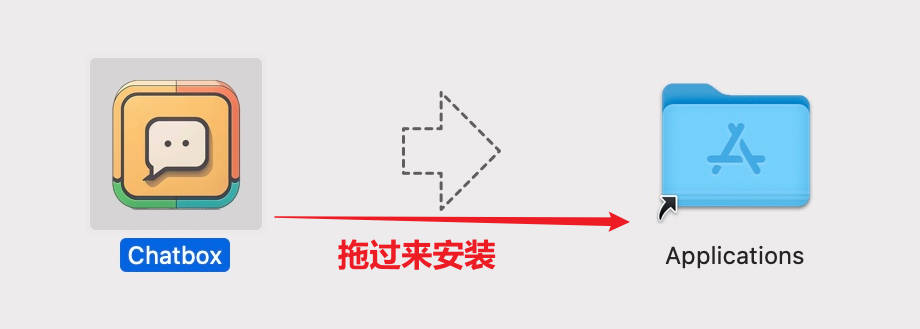

我这里还是Intel-based的MAC, 2、下载的Chatbox-1.9.7.dmg,大小100M多点,点击安装,按下面提示拖到Applications内:

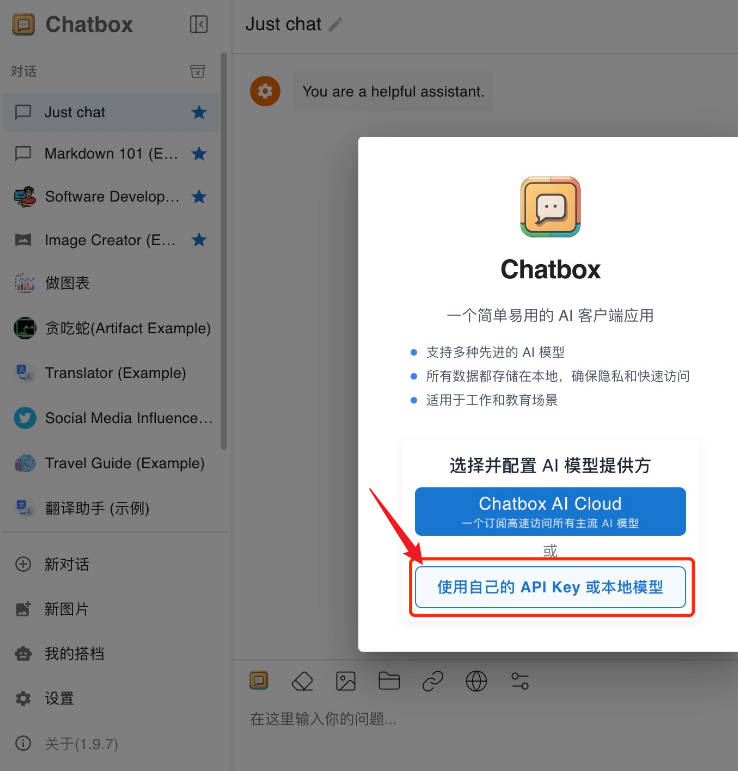

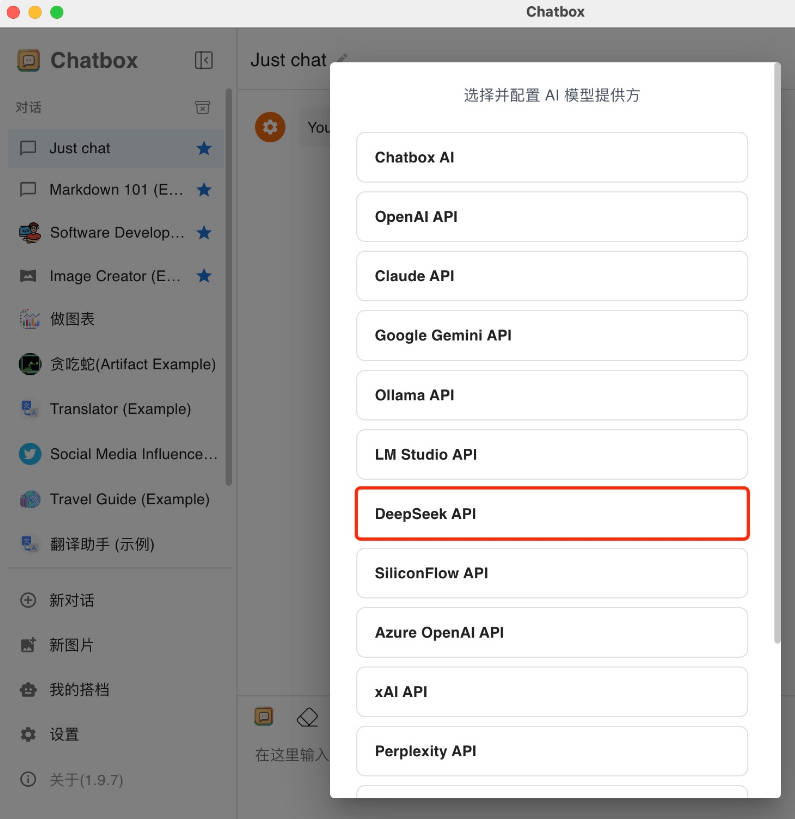

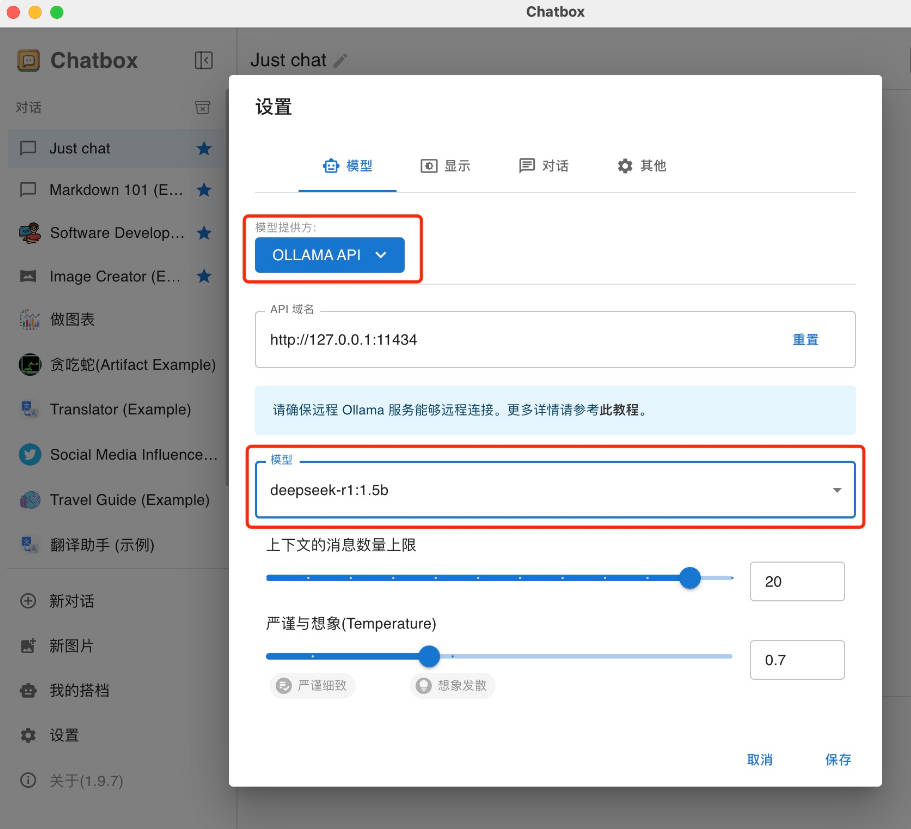

3、注意,这里我故意选错成DeepSeek API,这也是初学者经常会选错的,实际上,若选择这个你就找不到你本地的DeepSeek模型。 实际正确应该选择OLLAMA API,然后就可以看到我们上一步安装好的deepseek-r1:1.5b。

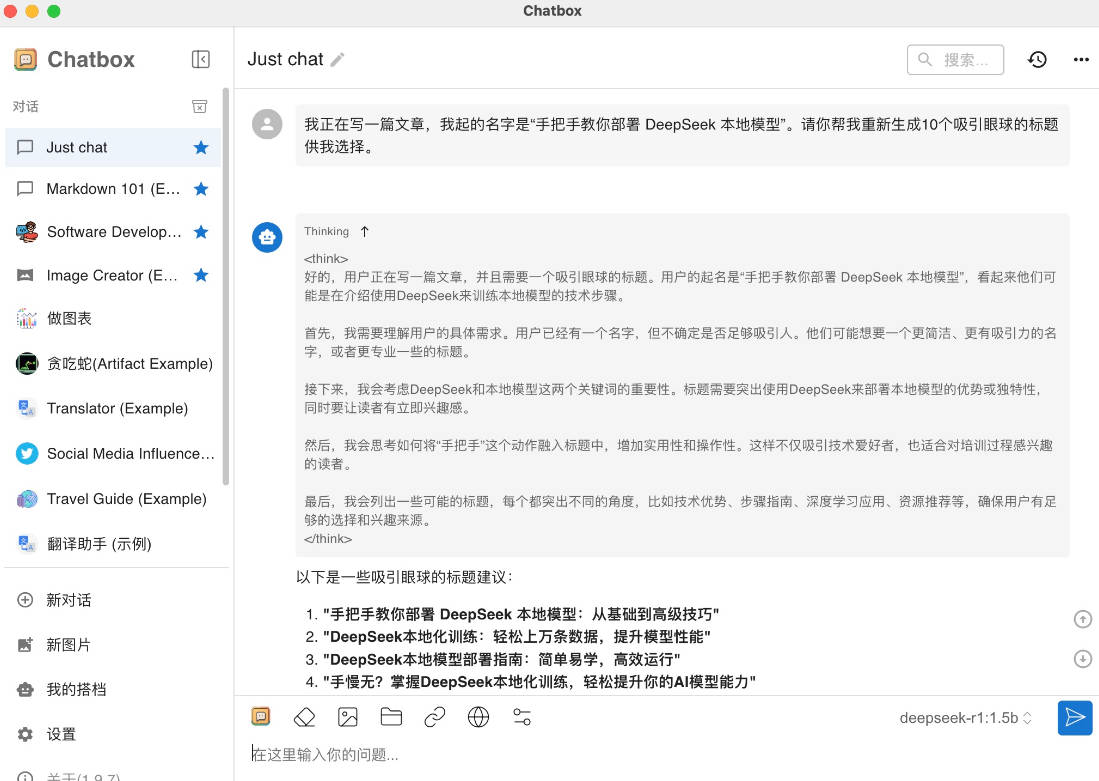

配置好DeepSeek本地模型之后,就可以实现在断网情况下自由问答了,比如,此刻我正在写这篇文章,于是就问他帮我想几个备选的标题:

他真的迅速给我起了10个吸引眼球的标题,还提供了它思考的过程,而且在我这4年前的电脑上跑起来都很迅速。 好了,以上就是苹果电脑Macbook本地部署DeepSeek教程指南的全部内容了,你学会了吗? (责任编辑:) |